人工知能(AI)は急速に進化しており、産業を変革し、組織とテクノロジーの関わり方を再構築しています。この進化の中心にあるのが、OpenAIのChatGPTやGoogle Geminiのような大規模言語モデル(LLM)です。これらのモデルは自然言語を理解し生成する能力に優れ、さまざまなビジネス領域で価値を発揮しています。

しかし、LLMには本質的な限界もあります。彼らの知識は事前に学習されたデータのみに基づいているため、静的で古くなったり、不完全であったりする可能性があります。その結果、不正確または誤解を招く結果を生成することがあり、専門的またはリアルタイムの質問には対応しきれないこともあります。

これらの課題を克服するために登場したのがリトリーバル強化生成(RAG)です。このアプローチは、LLMの生成能力と外部知識の高精度な検索を組み合わせることで、より正確で信頼性が高く、ビジネスに適したAIソリューションを実現します。

リトリーバル強化生成(RAG)とは?

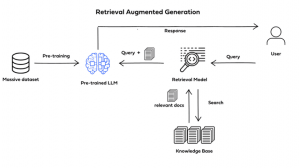

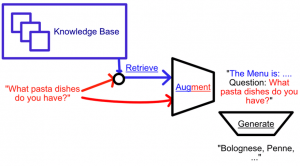

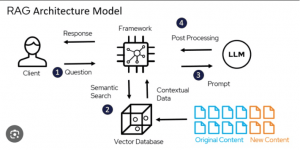

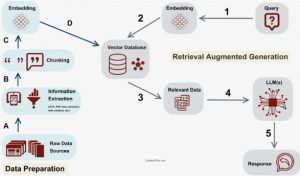

リトリーバル強化生成(RAG)は、大規模言語モデル(LLM)の応答生成を向上させるために設計されたAI手法です。モデルの事前学習知識だけに頼るのではなく、RAGはAPI、オンラインコンテンツ、データベース、文書リポジトリなどの外部知識ベースから情報を取得するリトリーバーコンポーネントを統合しています。

RAGはLLMへのフィードバック品質向上のために開発されました。

RAGはLLMへのフィードバック品質向上のために開発されました。

リトリーバーは、異なるレベルの意味的精度と深さを達成するためにカスタマイズ可能で、一般的には以下のようなものが用いられます:

- ベクターデータベース:ユーザーのクエリを高密度なベクトル埋め込み(BERTのようなトランスフォーマーモデルを使用)に変換し、類似検索を行います。あるいは、TF-IDFによるスパース埋め込みも用いられます。

- グラフデータベース:知識をテキストから抽出されたエンティティ間の関係として構造化します。高い精度が得られますが、初期クエリの精度が非常に重要です。

- SQLデータベース:構造化情報の保存に適しており、意味的な検索タスクには柔軟性は劣ります。

RAGは特に、インターネット上に散在する膨大な非構造化データの処理に効果を発揮します。これらのデータは豊富ですが、ユーザーのクエリに直接答えるようには整理されていません。

そのため、RAGはバーチャルアシスタントやチャットボット(例:Siri、Alexa)で広く採用されています。ユーザーが質問すると、システムは利用可能な情報源から関連情報を取得し、明確で簡潔、かつ文脈に合った正確な回答を生成します。例えば、「ABCリモコンのリセット方法は?」と聞かれた場合、RAGは製品マニュアルから手順を抽出し、わかりやすい回答を返します。

外部知識の検索とLLMの能力を組み合わせることで、RAGはユーザー体験を大幅に向上させ、専門的または複雑な状況でも正確かつ信頼できる回答を可能にします。

RAGモデルはバーチャルアシスタントやチャットボットでよく利用されています。

なぜRAGが重要なのか?

OpenAIのChatGPTやGoogle Geminiのような大規模言語モデル(LLM)は、自然言語処理の新たな基準を打ち立てています。理解、要約、コンテンツ生成、予測など多岐にわたる能力を発揮しています。しかし、その性能がいかに優れていても、限界がないわけではありません。タスクが専門的知識や最新情報を必要とする場合、LLMは流暢でも事実と異なる出力(AIハルシネーション)を生むことがあります。

この課題は企業の現場でさらに顕著となります。組織は大量の独自情報(技術マニュアル、製品ドキュメント、ナレッジベースなど)を管理していますが、汎用モデルではこれらを適切に扱うのが困難です。GPT-4のような長文処理可能な先進モデルですら、「中間での情報喪失」効果によって、重要な詳細を見落とす問題があります。

リトリーバル強化生成(RAG)は、こうした課題に対する解決策として登場しました。検索機構を統合することで、RAGはLLMが外部情報源(公開データや社内リポジトリ)から直接情報を引き出せるようにします。これにより、モデルの知識のギャップを埋めるだけでなく、ハルシネーションのリスクも減らし、検証可能な情報に基づく応答が可能となります。

チャットボット、バーチャルアシスタント、QAシステムなどの用途で、検索と生成の組み合わせは大きな進歩をもたらし、正確・最新・文脈に即したやり取りを実現し、企業が安心して利用できるAIとなっています。

RAGは、LLMが外部の情報源から情報を取得できるようにすることで、AIのハルシネーションを抑制します。

RAGは、LLMが外部の情報源から情報を取得できるようにすることで、AIのハルシネーションを抑制します。

リトリーバル強化生成のパイプライン

リトリーバル強化生成のパイプライン

RAGのメリット

RAGは単体のLLMと比べていくつかの重要な利点を持っています:

- 最新知識:モデルの再学習なしで最新情報を動的に取得可能。

- ハルシネーション減少:根拠ある回答で虚偽生成リスクを最小化。

- 透明性:情報源を明示し、ユーザーが主張を検証可能。

- コスト効率:頻繁な再学習サイクルが不要になり、計算・コスト負担を削減。

- スケーラビリティ:医療、金融、企業ITなど多くの分野で活用可能。

- 多用途性:チャットボット、検索システム、知的要約ツールなど多彩な用途に対応。

産業横断的な実用例

RAGは、ChatGPTやGeminiなどの事前学習データのみに依存しやすいモデルの限界を克服する鍵として注目されています。

言語モデルの生成力と外部データ検索を組み合わせることで、RAGは明確でリアルタイムな回答を提供し、AIハルシネーションを最小化し、企業のコスト最適化にも貢献します。

実際、RAGはすでにさまざまな分野でAIの未来を形作っています:

- チャットボット・カスタマーサービス:製品マニュアルやFAQ、ナレッジベースから直接回答を取得し、即時かつ正確な対応を実現。

- 医療:認証された臨床ガイドラインや研究データベースから情報を取得し、信頼できる医療知見を提供。

- 金融:リアルタイムの市場情報やデータフィードから文脈に合った洞察を提供。

- ナレッジマネジメント:従業員が技術文書や規制資料と自然言語でやり取りできるよう支援。

これらの実用例は、RAGがAIの信頼性・透明性・価値を産業横断的に高めていることを示しています。

将来展望

RAGは信頼できる権威あるAIへの大きな一歩です。パラメータ化された知識(学習済み知識)と検索による知識(動的かつ外部データ)を橋渡しすることで、LLMの最大の限界の一つを克服します。

今後、検索・推論・生成を自律的に制御するエージェンティックAIの進展により、RAGはさらに進化します。NVIDIAのGrace Hopper Superchipのようなハードウェアアクセラレーションや、LangChainのようなオープンソースフレームワーク、FPT AI Factoryのようなエンタープライズ向け高性能GPUインフラの支援により、RAGはエンタープライズグレードの生成AIの中核基盤へと成長し続けるでしょう。

最終的に、リトリーバル強化生成は単なるハルシネーションや知識ギャップの解決策にとどまらず、インテリジェントアシスタント、高度なチャットボット、産業向けAIシステムの基盤として、あらゆる分野で活躍することになるのです。

FPT AI Factoryの詳細はこちら:https://fptcloud.com/ja/product/fpt-ai-factory-ja/

ホットライン:0800-300-9739

メール:support@fptcloud.jp